Priorytety różnych obszarów analityki w organizacjach

Podczas warsztatów Power BI Dashboard In A Day (#DIAD) zadajemy uczestnikom pytanie o określenie priorytetów różnych obszarów analityki w organizacji. W obszarze raportowania i wizualizowania danych uczestnicy wskazali następujące priorytety: 78,3% – wysoki, 21,7% – średni. W obszarze zaawansowanych analiz: 32,6% – wysoki, 52,2% – średni, 15,2% – niski. W obszarze hurtowni danych w chmurze: 23,9% – wysoki, 39,1% – średni, 37% – niski. W obszarze data governance: 37% – wysoki, 52,2% – średni, 10,8% – niski. W obszarze wsparcia planowania i budżetowania: 50% – wysoki, 34,8% – średni, 15,2% – niski. Podsumowując, większość uczestników wskazało, że wymienione obszary analityki mają wysoki i średni priorytet wdrożenia w organizacji. Nikt z ankietowanych nie wskazał na niski priorytet w obszarze raportowania i wizualizowania danych. Jedynie w przypadku nowoczesnej hurtowni danych w chmurze ponad jedna trzecia osób wskazała na niski priorytet wdrożenia. Wyniki opracowano na podstawie 46 ankiet zebranych w dniu 27 kwietnia podczas warsztatów Dashboard In A Day.

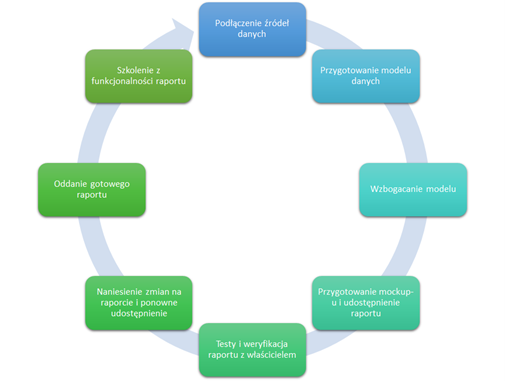

Patrząc na te odpowiedzi można dojść do wniosku, że w pierwszej kolejności organizacje chcą uporządkować obszar raportowania (#BusinessIntelligence, #Dashboards, #KPI). Nowoczesne technologie raportowe, takie jak np. Microsoft Power BI, pozwalają na szybkie uruchomienie takiego środowiska raportowego. Już po kilkudniowym szkoleniu z projektowania raportów w organizacji pracownicy tworzą pierwsze wizualizacje danych. Kolejnym krokiem jest udostępnienie ich w ramach zespołu lub całej organizacji. Ta często działa według określonego procesu wytwórczego raportu. Przykład takiego procesu ilustruje poniższy diagram.

Kolejnym krokiem, budowania spójnej platformy podejmowania decyzji, jest uruchomienie rozwiązania do wsparcia procesu planowania i budżetowania (#Planning&Budgeting, #CorporatePerformanceManagement, #FinancialPlanning&Analysis, #Sales&OperationsPlanning). Wdrożenie nowoczesnej platformy planistycznej pozwala zaoszczędzić mnóstwo czasu, który do tej pory kontrolerzy poświęcali na utrzymanie i aktualizację arkuszy kalkulacyjnych. Systemy klasy CPM takie jak np. IBM Planning Analytics są świetnym sposobem na powiązanie planów finansowych i operacyjnych opartych o różne źródła danych. Pozwalają na spójne modelowanie czynników mających wpływ na rozwój biznesu, poprzez tworzenie aktualnych i wiarygodnych prognoz i analiz typu what-if. Efektem tych wszystkich działań jest zwiększenie dokładności planów, zmniejszenie odchyleń budżetowych oraz ograniczenie ryzyka i kosztów.

Po zweryfikowaniu obszarów raportowania i planowania, organizacje zaczynają myśleć o uporządkowaniu danych i metadanych, wprowadzając procedury, procesy i dobre praktyki (#Data Governance). Przykładowo jednym z rozwiązań wspierających ten proces jest rozwiązanie Microsoft Purview dzięki któremu firmy zapewniają ład w danych w celu zmaksymalizowania ich wartości biznesowej. Automatyzacja odnajdowania danych, klasyfikacji danych poufnych i kompleksowych informacji o pochodzeniu danych pomaga data stewardom z łatwością tworzyć pełną i aktualną mapę krajobrazu danych firmowych.

Po wprowadzeniu ładu w danych, metadanych, przypisaniu odpowiedzialności i uspójnieniu pojęć biznesowych, kolejnym krokiem w rozwoju jest adopcja data science. Dobrym pomysłem jest stworzenie środowiska pracy dla data scientistów – sandbox data science (#DataScience). Zazwyczaj takie środowisko jest wyposażone w zestaw narzędzi wspierających pracę zaawansowanych analityków, począwszy od przygotowania danych, kompilowania i trenowania modeli, wsparcia pracy w zespole, a na industrializacji modeli kończąc (#MachineLearning). Podejście wpisuje się w zwinne metodyki pozwalające na szybkie tworzenie i wdrażanie modeli uczenia maszynowego bez względu na poziom umiejętności analityka. Ciekawym produktem wspierającym zautomatyzowane tworzenie modeli uczenia maszynowego jest rozwiązanie Azure Machine Learning.

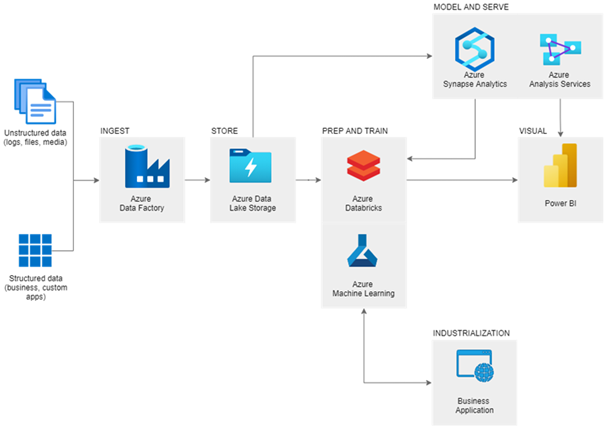

Migracja hurtowni danych do chmury, to dla większości organizacji pieśń przyszłości (#ModernDataWarehouse). Firmy przystępują do realizacji tego typu projektów zaraz po opanowaniu palących wyzwań, nawet jeżeli nowa hurtownia danych może mieć znaczący wpływ na wszystkie obszary wymienione powyżej. Liderzy nie chcą jednak odkładać tematu na później, widząc w tym szanse nie tylko związane z benefitami analityki w chmurze, ale także okazję na tworzenie kultury organizacji czerpiącej korzyści z danych (#DataDrivenCulture). Przykładowo w ofercie Microsoft Azure występuje szereg usług wspierających budowę nowoczesnej hurtowni danych wraz z całym środowiskiem analitycznym. Najczęściej używanymi usługami są Azure Data Factory, Azure Data Lake, Azure Data Bricsks, Azure Synapse Analytics, Azure Analysis Services oraz w warstwie wizualizacyjnej Microsoft Power BI.

Opcjonalnym rozwiązaniem wspierającym tworzenie nowoczesnych środowisk analitycznych jest użycie technologii hurtowni danych Snowflake w warstwie modelowania danych zorientowanych biznesowo i tematycznie (#DataMarts). Snowflake to ultraszybka analityczna baza w chmurze, która dostosowuje się automatycznie do potrzeb np. związanych z wykorzystaniem większej mocy obliczeniowej, przyjęcia zwiększonej ilości danych lub żądania wykonania operacji w tym samym czasie. Technologię Snowflake można uruchomić również na platformie Azure, ciesząc się prawie bezobsługową pracą bazy danych, a także dodatkowymi funkcjonalnościami np. możliwością przywrócenia dowolnego stanu obiektów bazy danych do 90 dni, klonowaniem obiektów bez konieczności kopiowania danych, możliwością wykorzystania danych udostępnionych przez innych usługodawców.

Poniższy diagram pokazuje przykładową architekturę nowoczesnej hurtowni danych w oparciu o usługi Microsoft Azure.

Uruchomienie nowoczesnej hurtowni danych w chmurze jest dla organizacji zawsze dużym wyzwaniem. Tego typu wdrożenia zaczynają się często od projektu pilotażowego – Proof of Value, podczas którego prezentowany jest proces End to End: zbieranie danych, transformacja danych, budowa modelu danych, eksploracja danych, budowa raportów i analiz predykcyjnych, tworzenie kokpitów menedżerskich, udostępnianie wszystkich analiz oraz praca zespołowa z udostępnionymi raportami i kokpitami. Ważnym elementem projektu jest zbudowanie kompetencji zespołu, w celu lepszego zrozumienia nowoczesnego środowiska analitycznego w chmurze oraz jego dalszego rozwoju. Dobrą praktyką jest, aby podczas projektu pracować warsztatowo już od samego początku. W APN Promise zaczynamy od transferu wiedzy na temat platformy analitycznej w chmurze – Microsoft Azure wraz z różnymi usługami wchodzących w jej skład. Następnie kluczowymi punktami projektu są analityczne spotkania warsztatowe, których celem jest zebranie wymagań dotyczących infrastruktury, danych i architektury. Efektem końcowym spotkań analitycznych jest przedstawienie koncepcji architektury wraz planem uruchomienia usług Azure. Projekt kończą warsztaty pokazujące: działanie technologii zastosowanych w architekturze, wizję rozwoju środowiska, istniejące kompetencje oraz ich braki. Na koniec klient otrzymuje dokumentację wraz z wyceną szacowanych kosztów docelowego środowiska w modelu pay as you go. Wszystkie działania wykonywane są w środowisku zbliżonym do rzeczywistego. Po skończonym projekcie klient może testować nowe środowisko zgodnie z różnymi scenariuszami odzwierciedlającymi realną pracę.